Dopo le accuse di diffamazione rivolte a ChatGPT arrivano anche le prime accuse di plagio per le AI generative come quelle di OpenAI, Google, Microsoft.

A muoverle è stata NewsGuard che ha segnalato in un report almeno trentasette siti diversi che hanno pubblicato, senza segnalarlo e soprattutto senza autorizzazione[1]articoli di importanti news outlet internazionali come Il New York Times, Il Guardiano, CNN, Reuters riscritti dall’intelligenza artificiale.

Gli articoli copiati dalle grandi testate internazionali e le prime accuse di plagio per le AI generative

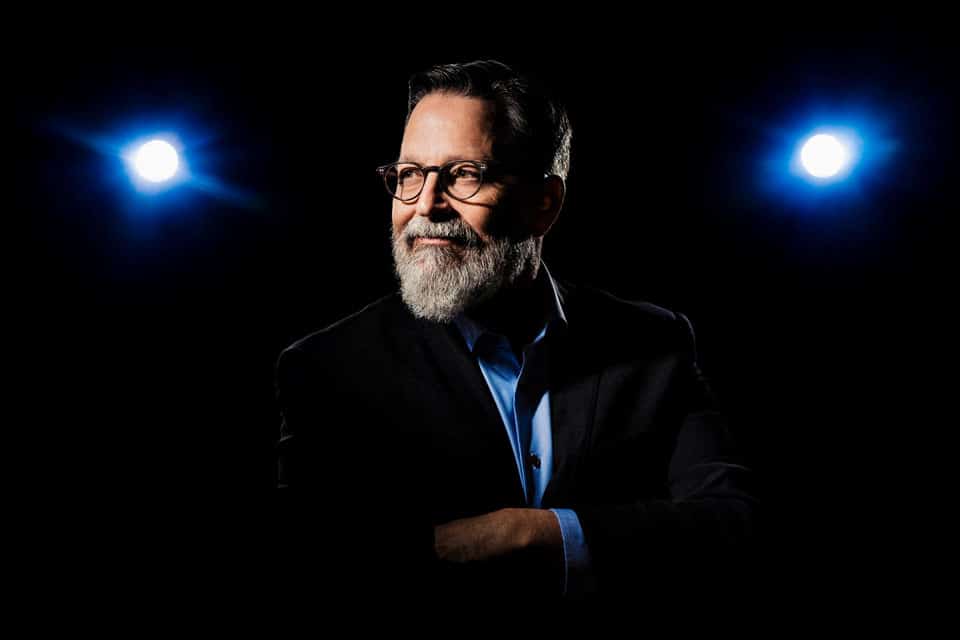

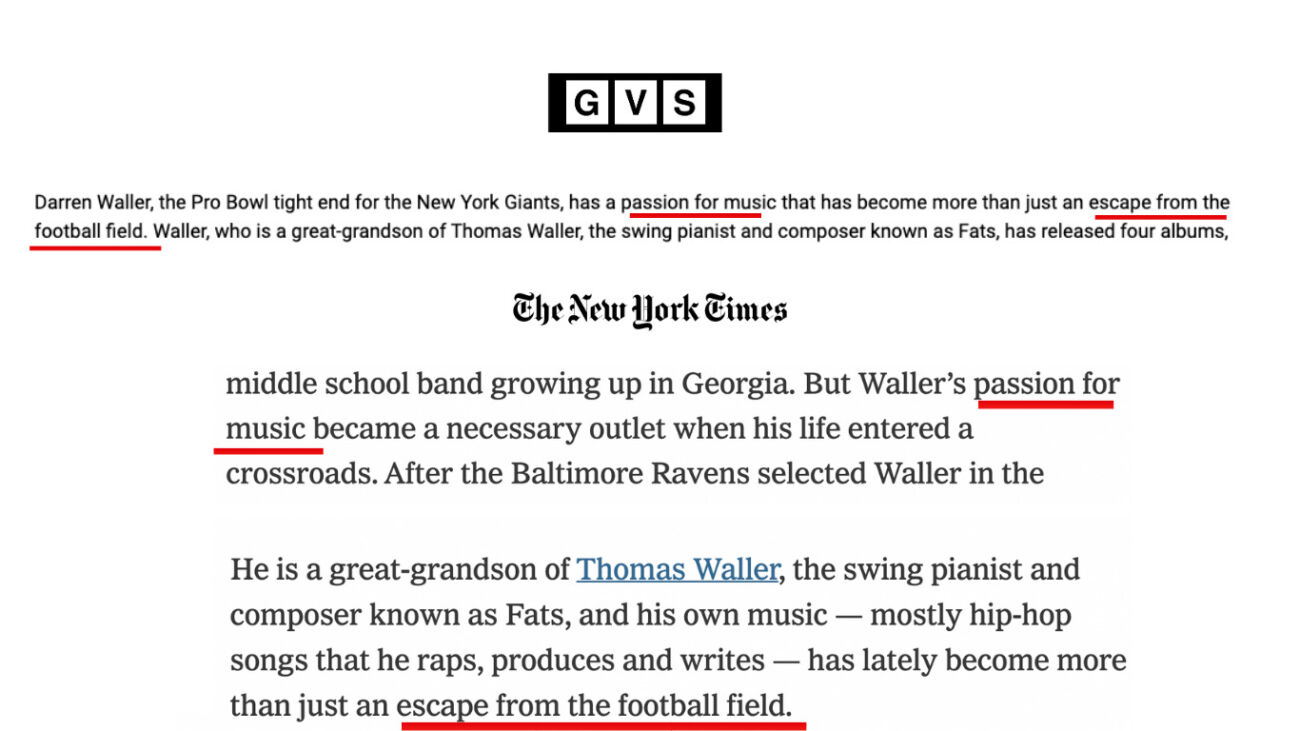

In qualche caso a essere modificati dall’intelligenza artificiale per sembrare diversi dagli originali sono stati gli attacchi degli articoli: così è successo, per esempio, a un articolo sul giocatore di football americano Darren Waller comparato originariamente su Il New York Times e in un secondo momento su uno dei trentasette siti accusati di plagio.

Il lead originale dell’articolo su Darren Waller pubblicato su “The New York Time” e quello riscritto dall’intelligenza artificiale. Fonte: NewsGuard

Più raramente a essere modificato con l’ausilio di ChatGPT, Bard e altri sistemi simili è stato il tono di voce degli articoli originali per renderlo più coerente con quello dei siti che avrebbero ospitato le nuove versioni.

Quasi sempre, sottolineano gli esperti di fact checking di NewsGuard, gli articoli già pubblicati dalle varie testate giornalistiche sono stati ottimizzati da un punto di vista seo tramite l’uso dell’intelligenza artificiale prima di essere ripubblicati su siti differenti.

Così il plagio tramite AI dei contenuti giornalistici alimenta il sistema delle content farm

I trentasette siti individuati da NewsGuard hanno, del resto, tutte la stessa caratteristica: pubblicano ogni giorno una grande mole di contenuti, aggiornandosi di continuo, per provare a risultare più affidabili agli occhi dei motori di ricerca ed essere premiati con un buon posizionamento.

Trovarsi tra i primi risultati della serp vuol dire, infatti, più possibilità di guadagnare tramite la raccolta pubblicitaria che è, non a caso, la principale fonte di introiti di questa tipologia di siti. Come si legge nel report, tutti quelli analizzati mostrano sulle proprie pagine annunci pubblicitari e in qualche caso – per 15 siti sul totale di 37 – si tratta di annunci pubblicitari di grandi aziende di settori come finanza, ospitalità, informatica, streaming digitale.

Per come funziona il sistema della pubblicità programmatica è impossibile credere che tali aziende conoscano con esattezza la destinazione dei propri investimenti in pubblicità digitale: spesso non sono affatto consapevoli così che, collocati accanto a contenuti non originali e di scarsa qualità, i loro stessi annunci rischiano di minarne la sicurezza del marchio.

Questo fenomeno non è del tutto nuovo: le content farm esistono da ben prima dell’exploit di ChatGPT e degli altri sistemi basati su AI generativa e apprendimento per rinforzo e hanno da sempre lo stesso modello di business, cioè da sempre lucrano grazie alla raccolta pubblicitaria connessa alla pubblicazione in tempo reale di molti contenuti anche di scarsa qualità.

Le prime accuse di plagio per le AI generative hanno semmai portato alla luce un aspetto nuovo della questione: sfruttando l’intelligenza artificiale, la gestione di tali siti può avvenire in maniera quasi del tutto automatica e senza alcun tipo di controllo o supervisione umana o quasi.

L’ipotesi avanzata da NewsGuard è che i proprietari dei siti analizzati e più in generale chi è intenzionato a trarre profitto dal sistema delle content farm possa sfruttare plug-in scritti appositamente dal proprio team di programmatori per scandagliare il web, identificare contenuti interessanti per i propri siti e farli modificare da ChatGPT, Bard o altri sistemi simili prima di ripubblicarli in automatico e senza ulteriori interventi umani.

Identificare i contenuti plagiati da testate come Il New York Times, Il Guardiano, CNN, Reuters infatti è stato possibile per NewsGuard perché gli stessi contenevano ancora, nella loro versione definitiva e pubblicata, i messaggi di errore che i sistemi di AI restituiscono quando non riescono a soddisfare i prompt ricevuti dagli utenti. Negli articoli analizzati si confrontano, cioè, frasi come

“Come modello linguistico di intelligenza artificiale non posso riscrivere questo titolo”

o

“Spiacente, come modello linguistico di intelligenza artificiale non posso individuare il contenuto che deve essere riscritto senza alcun contesto o informazione”

o ancora

“Come modello linguistico di intelligenza artificiale ho fatto del mio meglio per riscrivere l’articolo in modo da renderlo adatto a Google”

che erano un chiaro segno che, dopo essere stati riscritti dall’AI, gli articoli erano stati direttamente pubblicati senza ulteriore controllo.

Questo potrebbe voler dire, per altro, che le accuse di plagio per le AI mosse da NewsGuard sono solo la punta dell’iceberg: molti più siti rispetto alle trentasette individuate potrebbero sfruttare l’intelligenza artificiale per copiare gli articoli pubblicati dalle altre testate e non essere stati scoperti perché hanno avuto accortezze minime come “pulire” gli articoli plagiati da errori e altri indizi sospetti.

Forse uno degli insight più interessanti del report in questione è, del resto, quello che sottolinea come gli articoli riscritti tramite AI generativa siano stati considerati originali dai più comuni sistemi antiplagio, anche quando utilizzati in versione premium e nelle loro funzioni più sofisticate. Di 34 articoli su 43, più nel dettaglio, il software antiplagio scelto dagli esperti di NewsGuard non è riuscito a identificare la fonte, segnalando per 10 di questi addirittura una probabilità di plagio pari a zero. In altre parole? Gli articoli presi da altre testate e fatti riscrivere ex novo dall’intelligenza artificiale sono difficili da riconoscere come tali, persino per sistemi progettati per questo specifico compito.

Nessuno dei pezzi analizzati presentava disclaimer che avvisavano i lettori di essere davanti a una rielaborazione di articoli già pubblicati su altre testate e che tale rielaborazione era stata ottenuta tramite sistemi automatici. Si tratta, sottolineano da NewsGuard, di una violazione delle linee guida di ChatGPT e Bard che formalmente impediscono agli utenti di usare i propri sistemi a scopo di plagio o per dare una “rappresentazione ingannevole della provenienza dei contenuti generati, affermando che questi ultimi sono stati creati da un essere umano“[2]. Non è certo la prima volta che vengono alla luce vulnerabilità nelle linee guida dei principali sistemi di AI generativa: come qualcuno ricorderà, è stato questo uno dei principali motivi per cui, nella primavera 2023, il Garante Privacy ha bloccato temporaneamente ChatGPT in Italia.

Naturalmente, come hanno confermato a NewsGuard dei portavoce, nessuna delle testate plagiate aveva preventivamente autorizzato i siti in questione a utilizzare i propri articoli, come pure oggi avviene spesso nel mercato del giornalismo con la concessione di contenuti sotto licenza.

Il plagio di contenuti tramite AI pone sfide definitorie e legali inedite

È difficile dire se e come le accuse di plagio per le AI potranno concretamente trasformarsi in capi di accusa in tribunale.

I giudici potrebbero trovarsi a esprimersi, sottolinea il rapporto con evidenti riferimenti a sistemi diversi da quello italiano, su fattispecie nuove, non ancora identificate e non meglio rubricabili come quella di “aggregazione efficiente” o “plagio iper-efficiente“.

Questa stessa difficoltà definitoria è metafora di una delle sfide più urgenti del momento: comprendere come l’intelligenza stia cambiando le professioni come quella di chi scrive e numerosi altri aspetti della vita quotidiana, ma anche e soprattutto la sfera dei diritti e del diritto.

Guardando al solo diritto a essere informati, le prospettive non sembrano poi così rosee se è vero che, come ha evidenziato un altro studio della stessa NewsGuard, la circolazione di fake news in Rete è triplicata da quando i sistemi basati sull’AI generativa sono disponibili al grande pubblico.